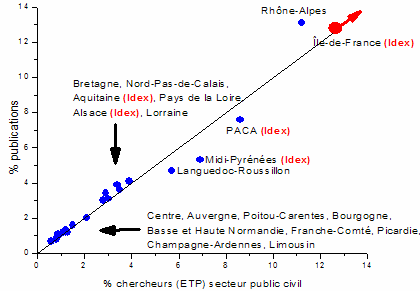

Gaïa Universitas a publié il y a quelques jours un billet intéressant intitulé “Excellence et productivité scientifique des ensembles régionaux”. Elle montre, notamment au travers de ce graphique, que le nombre de publications des Régions françaises est proportionnel à leur taille :

En gros, une région deux fois plus grande en nombre de chercheurs publie deux fois plus. Soit une productivité identique pour toutes les régions (j’ai dit en gros, on s’écarte parfois un peu de la droite, mais comme le signale Rachel, très bonne corrélation quand même).

Inévitablement, certains commentateurs se sont empressés de dire que “oui mais bon, dans les grandes régions, les publications sont sûrement de meilleure qualité quand même!!!”. Question légitime, plus difficile à trancher empiriquement. L’objectif de ce billet est d’apporter de premiers éléments de réponse.

Je m’appuie pour cela sur le travail réalisé par Michel Grossetti et son équipe sur Toulouse. Je vous avais déjà parlé du début de ce travail dans ce billet : les auteurs montrent qu’on assiste à un phénomène de déconcentration de la recherche pour différents pays. En France, l’Ile de France perd au profit des autres régions en termes de publication scientifique. En présentant ces résultats, Michel Grossetti s’est exposé à la même critique que celle avancée plus haut : “certes, l’Ile de France perd au profit des autres régions, son poids régresse dans les publications, mais les publications franciliennes sont de bien meilleure qualité!!!” (curieusement, ce sont souvent des chercheurs d’Ile de France qui émettent ce genre de remarque…).

Pour éprouver cette hypothèse, Michel Grossetti et Béatrice Millard ont poursuivi leurs investigations, synthétisées dans cet article. Ils retrouvent d’abord le mouvement de déconcentration de la recherche, au détriment des régions centres et au profit des régions intermédiaires et périphériques, et ce pour de nombreux pays (Etat-Unis, Royaume-Uni, France, etc.).

Surtout : ils se focalisent plus loin, pour la France, sur l’évolution de la concentration spatiale de l’ensemble des publications, d’une part, et du sous-ensemble des 10% des publications les plus citées (on considère la qualité d’une publication augmente avec le nombre de fois où elle est citée). En reprenant leurs chiffres, j’ai construit ce petit tableau, qui donne la part de l’Ile de France, de 1993 à 2003, dans :

| 1993 | 1998 | 2003 | |

| l’ensemble des publications (1) | 45% | 38% | 39% |

| les 10% des publications les plus citées (2) | 54% | 45% | 42% |

| ratio (1)/(2) | 1,21 | 1,19 | 1,09 |

En dix ans, l’Ile de France a vu son poids dans l’ensemble des publications baisser de six points de pourcentage, et du double (douze points) dans les publications les plus citées. Le ratio des deux chiffres, que l’on peut considérer comme une sorte d’indicateur de performance, reste certes supérieur à 1, mais il s’en rapproche dangereusement…

Conclusion? La production scientifique se déconcentre en France, mais la production scientifique de qualité se déconcentre encore plus vite…

Comment expliquer ce phénomène? J’avancerais une hypothèse : conformément à ce que disent Grossetti et Milard, le processus de déconcentration de la production scientifique est très lié aux évolutions démographiques. Les régions hors Ile de France ont des dynamiques plus favorables, donc plus d’étudiants, donc plus de création de postes d’enseignants-chercheurs, donc plus de publications. Si l’on considère en outre que les chercheurs et enseignants-chercheurs récemment recrutés produisent des recherches en moyenne de meilleure qualité que ceux des enseignants-chercheurs en poste depuis plus longtemps, on explique assez bien les chiffres observés : déconcentration de la production et déconcentration plus rapide de la production de qualité.