Introduction

Pour réduire l’activité d’une cellule, il existe deux mécanismes :

- Le mécanisme de contrôle de sélection et de re-sélection de cellule qui vise à interdire des UE à camper sur une cellule. L’état de la cellule est barré ou réservé.

- Le mécanisme de contrôle d’accès qui a pour objectif de contrôler la charge d’une cellule afin de réduire la congestion. Le mécanisme s’applique à des classes d’UE. La classe d’UE est définie au moment de l’inscription sur l’application USIM [25.304]. L’accès à la cellule est dit restreint.

Reprenons les définitions de la 3GPP sur les états de la cellule [TS 36.300]

- Barred Cell: Un UE ne peut pas camper sur une cellule barrée

- Reserved Cell: Un UE ne peut camper sur une cellule réservée que s’il satisfait à la condition d’autorisation.

- Restricted Cell: Un UE peut camper sur une cellule restreinte, mais la demande d’accès est conditionnée à la classe de l’UE et au service demandé.

Le standard définit 2 mécanismes différents :

- Réservations de cellules

- Barred Cell ou cellule barrée

- Reserved call ou cellule réservée

- Restriction d’accès

- Restricted cell ou cellule restreinte.

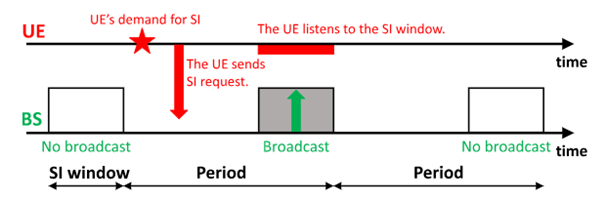

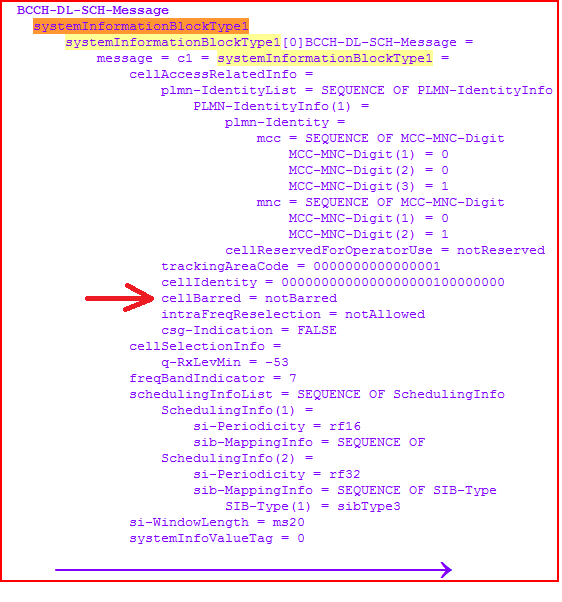

Afin d’informer l’état de la cellule, la station de base diffuse des informations systèmes :

- Le SIB1 transmet les informations de réservation de cellules : une interdiction de camper sur la cellule

- Le SIB2 transmet les informations relatives à la restriction d’accès selon la catégorie d’UE, selon le type d’information (signalisation ou Data) ou selon certains services (Session Data, CS ou VoLTE)

- Le SIB14 transmet des informations de restriction d’accès pour des terminaux de type IoT. La restriction d’accès ne concerne les souscriptions LAPI (Low Access Priority Indicator) pour lesquelles la durée de restriction d’accès est étendue par rapport aux timers du SIB2.

I) La sélection de cellule et la demande d’accès radio

Les mécanismes de sélection de cellule et de re-sélection de cellules sont expliqués dans les articles suivants

- Sélection de cellule

- Re-sélection de cellules :

La sélection et la re-sélection de cellules sont basées sur les informations de diffusion du SIB1 (cf. section III). Un UE ne peut camper que dans une cellule non interdite. L’interdiction de la cellule est diffusée dans le SIB1 à savoir si elle est barrée ou non ou si elle est réservée à l’opérateur (à titre d’exemple, en septembre 2021 Bouygues déployait son réseau NB_IoT et lors de la phase de test, le SIB1 n’autorisait que des accès aux terminaux de l’opérateur sur la cellule concernée).

L’UE doit sélectionner une cellule pour écouter les informations émises par cette cellule et pour pouvoir faire des demandes de connexion radio.

Le mécanisme d’accès à la cellule, nommé procédure d’accès aléatoire, permet à un UE de passer de l’état de veille (RRC IDLE) à l’état connecté (RRC CONNECTED). L’UE fait une demande de connexion radio auprès de la cellule sélectionnée (sur laquelle il campe). En 4G, les paramètres d’accès aléatoires RACH sont diffusés dans le SIB2. Cette demande peut être soit à l’initiative du mobile (Mobile Originated) pour transmettre de la signalisation ou des données, soit provoquée par le réseau suite à une notification, nommée procédure de paging (Mobile Terminated).

II) Contrôle d’accès radio : Restriction de cellule

Le contrôleur de la station de base [TS22.011] met en œuvre un mécanisme d’admission radio nommé Contrôle d’accès pour :

- Eviter la congestion de la station de base (celle-ci peut provenir d’un réveil de dispositifs, d’un mauvais dimensionnement lors d’un évènementiel, …). Sur quels critères la station de base émet une restriction ? 70% de la charge, 80% ??

- Eviter la congestion d’une entité du cœur de réseau (congestion). La station de base reçoit une information « Start Overload » de la part du cœur de réseau

La demande de connexion radio est mise en œuvre par la procédure d’accès aléatoire (RACH). Cette demande s’effectue sur le canal radio commun CCCH. Si plusieurs UE démarrent la procédure au même moment, alors les demandes s’interfèrent au niveau de l’eNB. La station de base peut traiter les demandes dont les valeurs de préambule sont différentes mais cette interférence limite déjà le nombre de connexion radio à l’insu de la station de base. Chaque UE qui n’a pas pu établir sa demande de connexion radio, recommence la procédure RACH.

Après avoir atteint le nombre maximum de tentatives d’accès RACH, l’UE abandonne la procédure RACH avec cette cellule et sélectionne une station de base voisine et redémarre la procédure RACH. Ainsi, en cas de congestion radio de la station de base, le risque est de reporter les UE qui n’ont pas pu réaliser leur connexion radio vers les stations de base voisines Cela aura pour effet de reporter la congestion radio vers les voisins.

La demande de connexion radio peut aussi être consécutive à la réception d’une notification de paging de la part de la station de base. On peut trouver surprenant que la station de base émette une notification de paging alors qu’elle est saturée.

Plusieurs raisons peuvent être avancées :

- La station de base n’a pas connaissance des UE qui sont sous sa couverture radio.

- Si on prend par exemple la restriction par classe d’UE, la procédure de paging s’adresse à un UE identifié par son IMSI/SUPI et non par sa catégorie.

- SI on prend la restriction d’appel sur un pourcentage, on pourrait supposer que la station de base limite la procédure de paging au pourcentage souhaité, soit p ce pourcentage. Mais le terminal qui reçoit le paging se voit de nouveau affecté par la restriction de connexion radio, il serait donc affecté au pourcentage p².

- SI l’UE ne reçoit pas de notification, alors il ne peut pas informer le cœur de réseau qu’il est toujours allumé. Dans ce cas, le cœur de réseau va détacher l’UE. Il est donc nécessaire que l’UE puisse au minima envoyer une réponse au cœur de réseau (message NAS) portée par une requête RRC.

Cela signifie alors que si la station de base est saturée, elle peut refuser l’établissement d’un bearer radio data DRB, mais il est nécessaire néanmoins de traiter les messages de signalisation RRC.

A partir de cette problématique, nous allons donc étudier la fonction de contrôle d’accès.

- Par catégorie : Restreindre l’accès radio (Access Class) à certaines classes d’UE (y compris les classes d’appels d’urgence)

- Par seuil (Access Baring Rate) pour réduire les tentatives de connexion radio en fonction de ce seuil

Le mobile doit vérifier les restrictions de la classe d’accès avant d’émettre une demande de connexion RRC CONNECTION REQUEST.

L’UE est informé de la congestion :

- soit par un message de refus d’accès radio suite à la procédure d’accès aléatoire (RRC Reject, se référer à l’article « Les Supports de Signalisation »)

- soit par un message de diffusion SIB2.

- Soit par un message de diffusion SIB14 qui empêche le mobile d’émettre une demande d’accès (procédure RACH) tant que la congestion n’est pas résolue.

Le mécanisme de restriction de cellule s’appuie sur deux concepts complémentaires :

- La classe d’accès des terminaux

- Le facteur de barrage

La classe d’accès ACB : Access Class Barring

La carte UICC (SIM/USIM) de chaque UE contient un numéro de classe d’accès compris entre 0 et 9. Ce numéro est défini lors de la souscription ou correspond au dernier numéro IMSI.

Certains terminaux peuvent être membres d’une classe d’accès comprise entre 11 et 15 mais ces valeurs sont réservées en général aux UE particuliers (autorités ou services d’urgence).

Afin de différencier les abonnés, les classes d’accès 0 à 9 peuvent avoir un accès restreint en cas de congestion. Les classes de classes 11 à 15 sont prioritaires et bien souvent non restreints. La restriction peut porter sur la donnée à émettre/recevoir ou sur un service.

On définit 3 mécanismes supplémentaires pour la restriction d’accès :

- Service-Specific Access Control (SSAC) o

- Network Slicing

- NAS Signaling

Le SSAC permet de contrôler l’accès pour des services spécifiques (comme la VoLTE et le service MMTEL) séparément des autres services.

La 5G introduit des fonctionnalités supplémentaires pour gérer l’accès à des slices de réseau spécifiques, ce qui permet une gestion plus fine de la qualité de service et des priorités.

Avec le Network Slicing, les différents slices du réseau 5G peuvent avoir des règles d’accès différentes. Par exemple, un slice pour les services critiques peut avoir une priorité d’accès plus élevée qu’un slice pour des applications de divertissement.

Non-Access Stratum (NAS) Signaling : Les messages de signalisation NAS sont utilisés pour gérer l’authentification, l’inscription et le contrôle d’accès des utilisateurs dans le réseau 5G.

Le facteur de barrage : Barring Factor

Même si l’UE n’est pas concerné par les messages de restriction sur les classes d’accès, la station de base peut néanmoins refuser l’accès radio lors de la tentative d’accès radio : l’UE choisit aléatoirement un numéro entre 0 et 1, nommé RAND (uniformément réparti), et compare la valeur tirée avec la valeur de restriction Barring Factor diffusée par l’eNB. Si la valeur tirée est inférieure à l’indicateur de restriction d’accès alors le mobile peut faire une tentative de connexion radio.

Par exemple, si le barring factor est de 0.3, il y a 70% de chances que l’UE ne puisse pas demander un accès radio.

Le durée de barrage : Barring Time

La durée de la restriction est calculée selon la formule suivante, avec ac-BarringTime qui à pour valeur possible (en s) : 1, 2, 4, 8, 16, 32, 64, 128, 256. Cette valeur est diffusée dans le SIB2 (cf. section IV)

T303= (0.7+ 0.6 * rand) * ac-BarringTime)

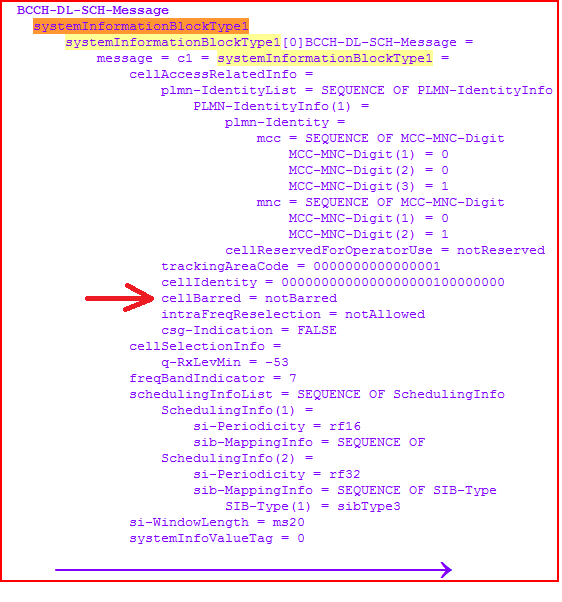

III) Les informations SIB 4G

III-1) Cell Baring (SIB1)

Les informations SIB1 défini l’état de la cellule,

III.2) ACB (SIB2)

L’Access Control and Barring (ACB) (contrôle d’accès et interdiction) est une fonction essentielle dans les réseaux 4G et 5G. Cette fonction est utilisée pour réguler l’accès des utilisateurs au réseau, lors de congestion du réseau (radio ou cœur de réseau).

Lorsque cette fonction est mise en œuvre, les UE concernés auront un accès réduit aux services, ce qui se traduit par une augmentation de la latence. Afin de respecter certains services, le blocage de l’accès radio peut être conditionné à une tranche d’utilisateurs ou à des services (ex LAPI : Low Access Priority Indicator). La station de base doit aussi être capable de discriminer les demandes de sessions Data de la signalisation (mobile originating and mobile terminating, mobile originating, or location registration) ainsi que pour les SMS.

Les UE prennent connaissance de la restriction d’accès à partir d’un message de diffusion SIB2 (ou SIB14 pour l’IoT).

< LTE SIB2 R.8 à R.11>

sib2

ac-BarringInfo

...1 .... ac-BarringForEmergency: True

ac-BarringForMO-Signalling

ac-BarringFactor: p00 (0)

ac-BarringTime: s4 (0)

ac-BarringForSpecialAC: 10000 (bitmap)

ac-BarringForMO-Data

ac-BarringFactor: p00 (0)

ac-BarringTime: s4 (0)

ac-BarringForSpecialAC: 00000 (bitmap)

....

ssac-BarringForMMTEL-Voice-r9

ac-BarringFactor: p00 (0)

ac-BarringTime: s4 (0)

ac-BarringForSpecialAC: 00000 (bitmap)

ssac-BarringForMMTEL-Video-r9

ac-BarringFactor: p00 (0)

ac-BarringTime: s4 (0)

ac-BarringForSpecialAC: 00000 (bitmap)

Le standard propose de restreindre l’accès radio pour les bearers suivants :

- envoyer de la signalisation : ac-BarringForMO-Signalling

- envoyer des données : ac-BarringForMO-Data

- accéder à des services téléphoniques : ssac-BarringForMMTEL-Voice-r9

Dans chacun des cas, on indique :

- le pourcentage de réduction à appliquer : ac-BarringFactor

- La durée ac-BarringTime: ac-BarringTime

- La classe affectée (Activation ou désactivation en fonction de la valeur du bit respectivement 1/0 selon la position du bit représentant les classes de 11 à 15 -bitmap) : ac-BarringForSpecialAC (ex : 10000)

A partir de la R.12, le mécanisme se complexifie en fonction de l’élément d’information IE du mobile. Se reporter à l’annexe 1.

IV) Conclusion

La congestion peut être réduite par le mécanisme ACB, avec un backoff radio pour demander à l’UE de différer sa demande d’accès. La congestion peut également provenir du cœur de réseau, l’entité concernée envoie un message START OVERLOAD aux stations de base concernée.

Concernant le paging, même si l’eNB met en œuvre le mécanisme ACB et si l’UE est concerné par la restriction, la station de base indique que l’UE est néanmoins autorisé à répondre à un Paging ou de réaliser la procédure de mise à jour de sa localisation.

Le mécanisme ACDC Application specific Congestion control for Data Communication est similaire au mécanisme ACB car il permet d’accepter ou de refuser des nouvelles demandes de connexions radio. Toutefois le mécanisme ACDC ne s’applique pas aux services voix MMTEL, et SMS over IMS

Dans le cas où la station de base est partagée (cf article RAN Sharing), si la congestion a lieu au niveau du cœur de réseau d’un opérateur, la station de base doit être capable de mettre en œuvre une restriction d’accès pour le cœur de réseau concerné.

Références

TS22.011 : 3GPP TS22.011Service accessibility (Release 19) – V19.3.0 (2024-03)

TS25.304 : 3GPP TS25.304: « User Equipment (UE) procedures in idle mode and procedures for cell reselection in connected mode ».

36.304 : 3GPP TS 36.304: « User Equipment (UE) procedures in idle mode »

ANNEXES SIB2 après la release 12

-EXTENSION ::= SEQUENCE [011111]

+-lateNonCriticalExtension ::= OCTET STRING OPTIONAL:Omit

+-VERSION-BRACKETS1 ::= SEQUENCE [11] OPTIONAL:Exist

| +-ssac-BarringForMMTEL-Voice-r9 ::= SEQUENCE OPTIONAL:Exist

| | +-ac-BarringFactor ::= ENUMERATED [p00]

| | +-ac-BarringTime ::= ENUMERATED [s4]

| | +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [00000]

| +-ssac-BarringForMMTEL-Video-r9 ::= SEQUENCE OPTIONAL:Exist

| +-ac-BarringFactor ::= ENUMERATED [p00]

| +-ac-BarringTime ::= ENUMERATED [s4]

| +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [00000]

+-VERSION-BRACKETS2 ::= SEQUENCE [1] OPTIONAL:Exist

| +-ac-BarringForCSFB-r10 ::= SEQUENCE OPTIONAL:Exist

| +-ac-BarringFactor ::= ENUMERATED [p00]

| +-ac-BarringTime ::= ENUMERATED [s4]

| +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [00000]

+-VERSION-BRACKETS3 ::= SEQUENCE [1111] OPTIONAL:Exist

| +-ac-BarringSkipForMMTELVoice-r12 ::= ENUMERATED [true] OPTIONAL:Exist

| +-ac-BarringSkipForMMTELVideo-r12 ::= ENUMERATED [true] OPTIONAL:Exist

| +-ac-BarringSkipForSMS-r12 ::= ENUMERATED [true] OPTIONAL:Exist

| +-ac-BarringPerPLMN-List-r12 ::= SEQUENCE OF SIZE(1..maxPLMN-r11[6]) [1] OPTIONAL:Exist

| +-AC-BarringPerPLMN-r12 ::= SEQUENCE [1111111]

| +-plmn-IdentityIndex-r12 ::= INTEGER (1..maxPLMN-r11[6]) [1]

| +-ac-BarringInfo-r12 ::= SEQUENCE [11] OPTIONAL:Exist

| | +-ac-BarringForEmergency-r12 ::= BOOLEAN [FALSE]

| | +-ac-BarringForMO-Signalling-r12 ::= SEQUENCE OPTIONAL:Exist

| | | +-ac-BarringFactor ::= ENUMERATED [p00]

| | | +-ac-BarringTime ::= ENUMERATED [s512]

| | | +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [10000]

| | +-ac-BarringForMO-Data-r12 ::= SEQUENCE OPTIONAL:Exist

| | +-ac-BarringFactor ::= ENUMERATED [p00]

| | +-ac-BarringTime ::= ENUMERATED [s512]

| | +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [00000]

| +-ac-BarringSkipForMMTELVoice-r12 ::= ENUMERATED [true] OPTIONAL:Exist

| +-ac-BarringSkipForMMTELVideo-r12 ::= ENUMERATED [true] OPTIONAL:Exist

| +-ac-BarringSkipForSMS-r12 ::= ENUMERATED [true] OPTIONAL:Exist

| +-ac-BarringForCSFB-r12 ::= SEQUENCE OPTIONAL:Exist

| | +-ac-BarringFactor ::= ENUMERATED [p00]

| | +-ac-BarringTime ::= ENUMERATED [s4]

| | +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [00000]

| +-ssac-BarringForMMTEL-Voice-r12 ::= SEQUENCE OPTIONAL:Exist

| | +-ac-BarringFactor ::= ENUMERATED [p00]

| | +-ac-BarringTime ::= ENUMERATED [s4]

| | +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [00000 | +-ssac-BarringForMMTEL-Video-r12 ::= SEQUENCE OPTIONAL:Exist

| +-ac-BarringFactor ::= ENUMERATED [p00]

| +-ac-BarringTime ::= ENUMERATED [s4]

| +-ac-BarringForSpecialAC ::= BIT STRING SIZE(5) [00000]

+-VERSION-BRACKETS4 ::= SEQUENCE [0] OPTIONAL:Exist

| +-voiceServiceCauseIndication-r12 ::= ENUMERATED OPTIONAL:Omit

+-VERSION-BRACKETS5 ::= SEQUENCE [11] OPTIONAL:Exist

+-acdc-BarringForCommon-r13 ::= SEQUENCE OPTIONAL:Exist

| +-acdc-HPLMNonly-r13 ::= BOOLEAN [FALSE]

| +-barringPerACDC-CategoryList-r13 ::= SEQUENCE OF SIZE(1..maxACDC-Cat-r13[16]) [1]

| +-BarringPerACDC-Category-r13 ::= SEQUENCE [1]

| +-acdc-CatValue-r13 ::= INTEGER (1..maxACDC-Cat-r13[16]) [1]

| +-acdc-BarringConfig-r13 ::= SEQUENCE OPTIONAL:Exist

| +-ac-BarringFactor-r13 ::= ENUMERATED [p00]

| +-ac-BarringTime-r13 ::= ENUMERATED [s4]

+-acdc-BarringPerPLMN-List-r13 ::= SEQUENCE OF SIZE(1..maxPLMN-r11[6]) [1] OPTIONAL:Exist

+-ACDC-BarringPerPLMN-r13 ::= SEQUENCE

+-plmn-IdentityIndex-r13 ::= INTEGER (1..maxPLMN-r11[6]) [1]

+-acdc-HPLMNonly-r13 ::= BOOLEAN [FALSE]

+-barringPerACDC-CategoryList-r13 ::= SEQUENCE OF SIZE(1..maxACDC-Cat-r13[16]) [1]

+-BarringPerACDC-Category-r13 ::= SEQUENCE [1]

+-acdc-CatValue-r13 ::= INTEGER (1..maxACDC-Cat-r13[16]) [1]

+-acdc-BarringConfig-r13 ::= SEQUENCE OPTIONAL:Exist

+-ac-BarringFactor-r13 ::= ENUMERATED [p00]

+-ac-BarringTime-r13 ::= ENUMERATED [s4]