Web 2.0

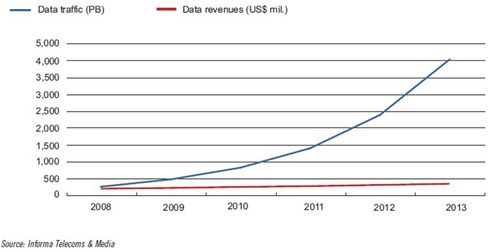

Ne soyez pas étonné de trouver dans un blog dédié à la téléphonie 4G, une part si importante consacrée aux conséquences d’Internet sur notre vie. Pourquoi un 4ème article? La 4G s’appuie sur le réseau IP de bout en bout, la 4G est un réseau de données.

Le terme 2.0 est régulièrement utilisé, on parle de web2.0, TELCO2.0 et entreprise 2.0.

Le 2.0, c’est quoi?

Pour simplifier, le web 2.0 est le web collaboratif : Le web 2.0 s’appuie sur la participation de tous les internautes, participation active dans la création de contenu (Wiki,

blogs, image, vidéo sur youtube), et participation passive dans le sens ou l’avis de l’utilisateur est pris en compte et le partage d’un même contenu profite à la communauté. Par exemple, c’est le cas du partage de ressource par BitTorrent : le service s’améliore automatiquement quand le nombre de ses utilisateurs croît.

Avec le web 2.0, le web est collaboratif et interactif, le web est basé sur le contenu de

l’ensemble de la communauté (la longue traine). Mais un contenu est inutilisable sans un outil pour récupérer l’information. Wais, Yahoo, Voila et msn ont été les premiers moteurs de recherche.

Ceux-ci étaient basés sur le nombre de mots clés présent dans les pages d’un site. Si je crée un site marchand pour vendre des Smartphones, il fallait utiliser le plus de mots Smartphones et téléphones mobiles dans mon site pour être bien référencé. L’astuce consistait donc à ajouter du texte avec une police non visible pour augmenter ce nombre ou ajouter des balises html avec les mots clés. La recherche était donc basée sur la taxonomie, il suffisait de savoir via quels mots clés l’internaute allait effectuer sa recherche.

Google a commencé son activité par un moteur de recherche mais avec des critères supplémentaires, comme le PageRank, c’est à dire un classement de notoriété de son site. A cette époque, il fallait multiplier le nombre de liens vers son site. Pour être bien référencé, il fallait faire des liens dans les portails, et partager des bannières entre internautes : Je fais un lien vers ton site et toi vers le mien. Un lien d’un site bien référencé a plus de valeur qu’un lien d’un site peu référencé. A cette époque (début 2000) Yahoo et voila se sont spécialisés dans les portails, une sorte d’annuaire et bien que cela semblait logique à l’époque, il s’agissait d’une erreur stratégique. Autre erreur stratégique, Yahoo a « ignoré » la longue traine, il triait les résultats en favorisant dans son classement . les sites importants mais n’indexait pas une myriade de sites mineurs qui fournissaient cependant des réponses à des questions plus précises.

Google n’a pas crée de contenu, mais un outil basé sur un moteur de recherche permettant de récupérer une information postée par un Internaute en optimisant le critère de recherche pour obtenir un résultat répondant plus précisément à la requête de l’utilisateur. C’est la rapidité et la pertinence des résultats du moteur de recherche Google qui a fait son succès. Google a ainsi été préféré aux autres moteurs de recherche et au méta-moteur comme Copernic. Pour éviter la multiplication des mots clés sur un site, Google a optimisé son robot pour détecter le spamindexing en sanctionnant les sites webs qui ne respectaient pas sa chartre de référencement.

Depuis 2009, Yahoo et Microsoft s’associe pour proposer un moteur de recherche appelé moteur de décision sous le nom de Bing. Personnellement, je n’ai pas noté de différence notable entre Bing et Google, en toute logique par rapport à la théorie de l’acception d’un modèle (Cf. Article précédent), je continue à utiliser Google.

Aujourd’hui, pour affiner la recherche des internautes, on référencie le contenu (texte, image ou vidéo) par des étiquettes (appelés Tag). En parallèle le langage html évolue vers le html5 (html5 fera l’objet d’un autre article).

Revenons au Tags, les tags ont un rôle prépondérant : Ils permettent de sélectionner les contenus à partager dans une communauté d’Internautes qui définissent eux même leur centre d’intérêt. Delicious.com avait initialement pour objectif de partager ses Marques pages (social bookmarketing) en abandonnant l’idée d’un classement par catégorie pour faire un classement de ses boolmark par catégorie. Les exemples sont nombreux, par exemple la syndication (lien RSS) permet de suivre le contenu sur un thème précis,

Twitter est probablement l’exemple le plus parlant, mais Youtube et Dailymotion pour la vidéo, Flickr pour le partage d’images sont aussi connus. Les tags permettent aussi d’optimiser les publicités qui s’affichent à votre écran par rapport à vos centres d’intérêts : fini les sites web avec des publicités statiques, ces bannières impersonnelles. Les publicités sont définies par rapport à votre position géographique, selon vos proxy et centre d’intéret. Le web est collaboratif, interactif et personnalisé. Google a d’ailleurs mis en place GoogleAdd permettant d’ajouter des bannières publicitaires relatives à la requête que vous effectuez.

Les sites ne sont plus référencés par leur arborescence (Taxonomie) mais par une indexation personnelle (Folksonomie – Folk : peuple, taxonomie). Le métier de référencement a donc beaucoup évolué et est maintenant un métier à part entière (SEO, Community Manager).

Le web 2.0 est un web dit à intelligence collective c’est à dire qui s’appuie sur l’activité collective de l’ensemble de ses utilisateurs. Des exemples? Facebook, et je pense que j’ai tout dit… Pas tout à fait, on peut aussi citer comme exemple ebay, Amazon qui s’appuient sur la e-réputation, c’est à dire sur l’implication de l’utilisateur :

Les consommateurs sont appelés à ajouter des commentaires et comme ebay peuvent évaluer le vendeur. Plus important encore, la recherche d’un produit sur Amazon se base sur l’activité des utilisateurs : Alors que les recherches de Barnesandnoble.com poussent les utilisateurs vers ses propres produits ou vers des résultats sponsorisés, Amazon renvoie toujours vers « les plus populaires », une notion calculée en temps réel non pas à partir des ventes mais à partir de ce que les gens d’Amazon appellent le «

flow » autour des produits. Il n’y a donc rien d’étonnant à voir la croissance des ventes d’Amazon dépasser celles de ses concurrents.

Dans un prochain article, nous parlerons la réputation internet.