Cet article reprend une partie des fonctionnalités déjà détaillées pour le NWDAF

Intégration de l’IA/ML dans le cœur 5G

La nouveauté majeure introduite dans la Release 15 du 3GPP est le Network Data Analytics Function (NWDAF), qui fournit divers résultats d’analyse pour soutenir un ensemble de cas d’utilisation.

Le NWDAF héberge différents algorithmes d’IA/ML alimentés par des données provenant de diverses fonctions réseau NF (Network Function). Il produit des résultats d’analyse spécifiques qui peuvent être consommés (en référence à l’architecture SBA ou les fonctions sont productrives ou consommatrices) par différentes fonctions réseau. Les exemples d’applications incluent:

- La prédiction des modèles de trafic pour optimiser le nombre d’instances UPF déployées

- La prévision de la mobilité des utilisateurs

- L’optimisation dynamique des ressources réseau

Les capacités IA/ML du NWDAF incluent des algorithmes de prédiction, des capacités d’IA générative, et des techniques de clustering.

Approches d’apprentissage pour les modèles IA/ML

Avec la disponibilité de volumes importants de données provenant de différentes sources à différents endroits, l’entraînement des modèles IA/ML peut adopter diverses approches:

- Apprentissage centralisé: Les modèles sont entraînés dans un emplacement centralisé avec des données agrégées.

- Apprentissage fédéré: L’entraînement se produit en continu dans différentes parties du réseau. Les modèles sont entraînés sur des nœuds locaux avec des sources de données locales et mis à jour par un modèle global entraîné dans un emplacement centralisé avec des sources de données agrégées. On distingue l’apprentissage fédéré horizontal et verticale (R.19)

- Approches alternatives: D’autres méthodes d’apprentissage distribuées peuvent être employées selon les cas d’utilisation spécifiques.

L’apprentissage fédéré améliore l’évolutivité, la sécurité et la précision en adaptant le modèle IA/ML aux données uniques spécifiques à chaque emplacement.

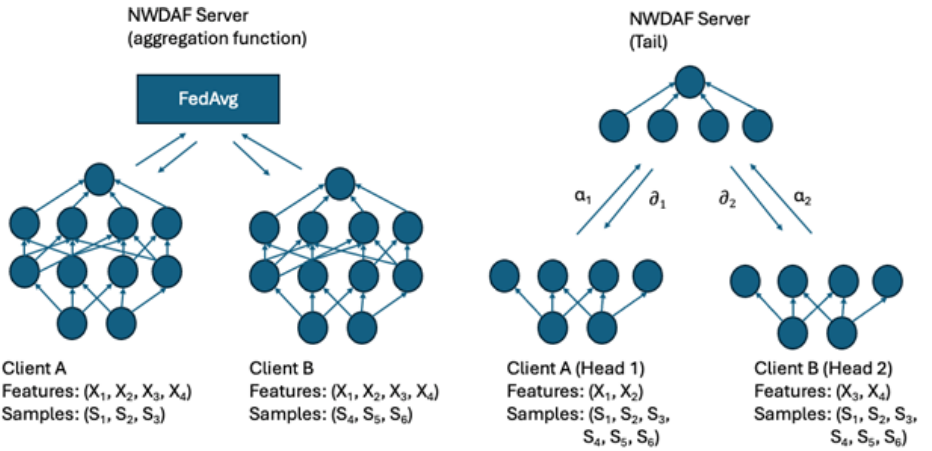

On distingue l’apprentissage fédéré horizontal (gauche Figure 1) et l’apprentissage fédérée verticale (droite Figure 1)

Figure 1 : Horizontal Federated Learning HFL (gauche) et Vertical Federated Learning VFL (droite)

Dans le cas du HFL, on alimente deux ML qui ont les mêmes caractéristiques avec des données complémentaires. Par exemple, deux opérateurs peuvent apporter un profil de leurs clients pour augmenter les données;

Dans le cas du VFL, on alimente deux ML avec des données complémentaires. Par exemple, on peut s’intéresser pour un client donnée de ses états MM et on complète par les états CM

Gestion de réseau assistée par IA pour le cœur du réseau

Orchestration et provisionnement automatisés

- Orchestration: L’IA/ML peut aider à automatiser les processus de provisionnement et à optimiser l’allocation des ressources pour diverses fonctions réseau.

- Détection d’erreurs de provisionnement: Les algorithmes d’IA/ML peuvent détecter les erreurs de provisionnement de manière automatisée, permettant des corrections proactives.

- Analyse des journaux de trafic: L’analyse GenAI des journaux de trafic, qui comprend un mélange de données non structurées et structurées, peut indiquer des défaillances potentielles, y compris la prédiction des défaillances et aider à identifier les causes profondes.

- Détection des failles de sécurité: Les violations de sécurité potentielles peuvent être détectées via des algorithmes d’IA/ML, aidant à décider de manière proactive de l’atténuation appropriée.

Amélioration de l’efficacité opérationnelle

Dans l’OSS/BSS, l’IA/ML et l’IA générative peuvent améliorer considérablement l’efficacité opérationnelle et l’expérience client:

- Gestion de l’expérience client: Les chatbots pilotés par l’IA peuvent gérer les requêtes courantes des clients.

- Facturation et assurance des revenus: La prédiction du taux d’abandon (churn predicting) basée sur l’IA/ML peut grandement bénéficier à ces domaines pour estimer à quel moment un client arrête le service demandé..

- Planification réseau: La planification réseau peut être soutenue par des techniques de prévision de trafic basées sur l’IA/ML.

En cas de défaillance, la gestion centralisée de plusieurs agents permet d’analyser différentes pistes afin de trouver la cause réelle de la panne. Par exemple, un appel VoNR qui s’arrête peut provenir de plusieurs causes : coupure radio, restauration du P-CSCF, TAS en erreur, routage erroné, … Les outils comme Agentic.ia va explorer les différents log et si un prestataire doit être contacté, l’outil peut générer le ticket client.

Network Data Analytics Function (NWDAF)

Introduction et évolution du NWDAF

Le NWDAF a été introduit à l’origine dans la Release 15 du 3GPP comme mécanisme pour rapporter des insights sur le fonctionnement du réseau. Ces insights peuvent ensuite être utilisés par d’autres fonctions pour réaliser une automatisation en boucle fermée afin d’améliorer le fonctionnement du réseau.

On appelle insight des connaissances exploitables ou des résultats d’analyse dérivés des données du réseau. Ces insights peuvent concerner par exemple les modèles de trafic, le comportement des utilisateurs, ou les performances du réseau, et sont utilisés par d’autres fonctions du réseau pour optimiser leur fonctionnement.

Le NWDAF réalise cela en:

- Collectant et agrégeant des données de différentes parties du réseau cœur

- Analysant ces données pour identifier des modèles et générer des prédictions via des algorithmes statistiques et basés sur le ML (y compris le DL)

- Respectant la confidentialité lors de la collecte de données, permettant aux utilisateurs de choisir de participer ou non à la collecte de données

Intégration avec d’autres fonctions réseau

Le NWDAF s’intègre avec d’autres fonctions réseau via une interface basée sur les services (SBI). Cette intégration permet à d’autres fonctions réseau de devenir des abonnés aux événements générés par le NWDAF et d’influencer le fonctionnement du réseau cœur en consommant ces événements.

Toute fonction réseau conforme au 3GPP, fonction d’application (AF) ou opération, administration et maintenance (OAM) devrait pouvoir utiliser les services d’analyse activés par le NWDAF en tant que consommateur pour prendre des décisions basées sur l’analyse dans le cadre de leurs procédures réseau.

Cas d’utilisation et services d’analyse

Différents cas d’utilisation ont été implémentés et pris en charge dans le NWDAF dans un environnement multi-fournisseurs. Le NWDAF de la version 16 de la spécification technique 29.520 [2] du 3GPP prend en charge les services d’analyse définis dans la TS 23.288 [1]:

- Analytique de charge de tranche réseau

- Analytique d’expérience de service

- Analytique de charge de fonction réseau

- Analytique de performance réseau

- Analytique de comportement anormal/attendu de l’UE

- Analytique de mobilité de l’UE

- Analytique de communication de l’UE

- Analytique de congestion des données utilisateur

- Analytique de durabilité de la QoS

Apprentissage fédéré dans le NWDAF

Le document détaille comment le NWDAF a évolué pour inclure des capacités d’apprentissage fédéré:

- Release 17: Le NWDAF a acquis la capacité d’effectuer un apprentissage fédéré horizontal (HFL), souvent simplement appelé apprentissage fédéré. Le HFL est une technique de ML préservant la confidentialité qui permet un entraînement de modèle collaboratif entre différentes zones d’intérêt.

- Fonctionnement du HFL: Chaque zone d’intérêt entraîne son modèle localement en utilisant le NWDAF le plus proche, et l’apprentissage collectif de plusieurs zones est ensuite agrégé via une fonction centrale sur le serveur NWDAF. Le processus est qualifié d' »horizontal » car chaque participant a le même espace de caractéristiques mais des échantillons différents.

- Avantages du HFL: Cette approche réduit le volume de données transférées sur le SBI, car seuls les paramètres neuronaux—améliorés par des protocoles préservant la confidentialité comme l’agrégation sécurisée—sont transmis, plutôt que les données brutes. La réduction du volume de données peut être encore améliorée via l’utilisation de techniques comme la distillation de connaissances, la quantification et l’élagage des paramètres neuronaux.

- Release 18: La Release 18 a introduit l’apprentissage fédéré et le transfert de modèle de machine learning entre différents domaines administratifs, comme les réseaux mobiles connectés par des accords d’itinérance, étendant davantage le cycle de vie des modèles initialement déployés dans le NWDAF.

- Release 19: La Release 19 introduit l’apprentissage fédéré vertical (VFL) dans le NWDAF entre les NWDAF et les fonctions d’application. Le VFL offre plusieurs améliorations par rapport au HFL:

- Chaque participant peut avoir sa propre architecture de réseau neuronal

- Chaque participant peut avoir son propre espace de caractéristiques

- Les nouvelles données, comme celles collectées dans les fonctions d’application, peuvent être utilisées en combinaison avec le réseau cœur pour entraîner de meilleurs modèles ML

- Applications du VFL: Des cas d’utilisation comme la prédiction de QoS utilisant l’entrée des fonctions d’application sont en cours de développement et bénéficient du VFL. Notamment, le VFL est introduit comme une extension de l’apprentissage fédéré, ce qui signifie que les cas d’utilisation existants peuvent également bénéficier de cette nouvelle fonctionnalité.

Fonctionnement du VFL vs HFL

Dans le VFL, le modèle ML est divisé en modèle de tête et modèle de queue. Le processus d’entraînement VFL implique:

- La propagation vers l’avant commence sur les modèles des Clients A et B

- Leurs activations sont communiquées au modèle de queue où elles sont concaténées

- Le modèle de queue effectue une propagation vers l’avant et calcule la perte en utilisant des étiquettes locales

- La rétropropagation commence et les dérivées partielles sont envoyées aux modèles de tête correspondants

- Chaque client effectue sa propre rétropropagation

- Le processus se poursuit avec plusieurs itérations jusqu’à ce que toutes les données aient été traitées

Du point de vue du 3GPP, HFL et VFL sont deux approches pour apprendre un modèle collaborativement sans partager de données. Ils sont spécifiés de manière agnostique au processus de HFL ou VFL, considérant plutôt une architecture client-serveur et la capacité de chaque nœud à prendre en charge HFL ou VFL et potentiellement d’autres techniques qui pourraient être introduites à l’avenir.

Gestion du cycle de vie et flux de travail dans le NWDAF

Les procédures introduites dans le NWDAF pour prendre en charge l’apprentissage automatique permettent la gestion du cycle de vie des modèles IA/ML dans le réseau cœur. La gestion du cycle de vie des modèles IA/ML est le processus ou l’ensemble de tâches nécessaires pour entraîner, mettre à jour et maintenir un modèle d’apprentissage automatique.

En raison de la nature basée sur les données des modèles d’apprentissage automatique, la gestion du cycle de vie des modèles IA/ML est essentielle car elle assure la reproductibilité de l’apprentissage automatique lorsqu’ils quittent l’environnement de science des données et passent en production.

La gestion du cycle de vie des modèles aborde des problèmes tels que:

- Comment entraîner et déployer un modèle à grande échelle

- La gouvernance, la qualité et la conformité des données

- La supervision du processus d’entraînement via des pipelines de traitement de données

- Les mécanismes pour se connecter aux sources de données et prétraiter les données

Le rôle de l’IA générative dans le cœur du paquet et les systèmes BSS/OSS

Amélioration du traitement des données

Le document explique que l’IA générative peut améliorer significativement le traitement et l’analyse des données dans les réseaux cœur et le NWDAF, ainsi que les systèmes OSS/BSS:

- Génération de données synthétiques: L’IA générative peut générer des données synthétiques pour compenser les lacunes ou enrichir les ensembles de données avec des informations limitées. Cela réduit le besoin de collecte extensive de données, ce qui diminue les coûts de communication et améliore la confidentialité lors du traitement de données sensibles.

- Jumeaux numériques: Dans le contexte du NWDAF, l’IA générative peut aider à créer des jumeaux numériques de fonctions réseau NF, permettant la simulation de divers scénarios. Par exemple, elle peut modéliser des conditions futures potentielles comme l’augmentation du trafic réseau et prédire leur impact sur des KPI comme la latence, le débit et la consommation d’énergie, tout en tenant compte de la durabilité.

Transformation des systèmes BSS/OSS

Les systèmes BSS/OSS, cruciaux pour soutenir les opérations et les fonctions commerciales d’un opérateur de télécommunications, peuvent grandement bénéficier de l’IA générative:

- Évolution des systèmes: Traditionnellement, les systèmes BSS/OSS s’appuyaient sur des requêtes SQL pour récupérer des données des bases de données. Cependant, avec l’avènement du big data, ces systèmes ont évolué pour incorporer l’IA et l’analytique avancée pour des insights plus profonds dans les opérations réseau.

- Capacités des LLM: L’IA générative, particulièrement les grands modèles de langage (LLM), offre de nouvelles capacités. Par exemple, les LLM peuvent traduire le langage naturel en requêtes SQL, rendant l’accès à l’information plus intuitif et éliminant le besoin d’une connaissance intriquée des schémas de base de données.

- Analyse de données améliorée: Les LLM peuvent améliorer l’analyse de données au sein des systèmes BSS/OSS grâce à des techniques comme la génération augmentée par récupération ou le fine-tuning, leur permettant d’intégrer les résultats avec des connaissances supplémentaires et de fournir des insights plus complets.

Applications pratiques

L’intégration des LLM dans les systèmes BSS/OSS promet des avantages significatifs pour les réseaux mobiles:

- Automatisation du dépannage: Les LLM peuvent être utilisés pour automatiser les processus de dépannage en exploitant les informations des tickets précédemment résolus pour la gestion du réseau.

- Service client: Les LLM peuvent agir comme un assistant virtuel infatigable fournissant une aide directe aux abonnés, améliorant l’expérience utilisateur et réduisant la charge sur le support client humain.

- Cybersécurité: Les LLM peuvent être utilisés pour générer de nouvelles attaques dans les réseaux mobiles, qui peuvent ensuite être utilisées pour développer des mécanismes de défense qui préviennent de telles attaques, renforçant la posture de sécurité globale.

Ces applications démontrent le potentiel transformateur de l’IA générative dans les opérations de réseau cœur et les systèmes BSS/OSS, conduisant à une efficacité opérationnelle accrue, une meilleure expérience client et une sécurité renforcée.

Processus de bout en bout pour le déploiement de l’IA dans les réseaux

Le document souligne que l’IA/ML peut être utilisée pour optimiser le fonctionnement de divers segments des réseaux cellulaires. Pour y parvenir, les processus d’entraînement de l’IA/ML et les moteurs d’inférence doivent être intégrés dans les différents segments des réseaux cellulaires et pris en charge pour la gestion de leur cycle de vie.

Réseaux pilotés par l’intention et IA

L’IA joue un rôle crucial dans les réseaux pilotés par l’intention, où elle et l’approche basée sur l’intention se renforcent mutuellement:

- L’IA aide à éliminer les goulets d’étranglement dans l’implémentation des intentions, tandis que les réseaux basés sur l’intention simplifient l’exécution des politiques d’IA, réduisant le besoin d’API traditionnelles.

- Les réseaux pilotés par l’intention représentent un changement de paradigme vers une approche de gestion de réseau plus dynamique et adaptative. Ils se concentrent sur la traduction d’objectifs commerciaux de haut niveau en politiques et configurations réseau exploitables.

L’IA améliore les réseaux pilotés par l’intention de plusieurs façons:

- Décisions contextuelles: L’IA améliore les réseaux pilotés par l’intention en permettant une prise de décision contextuelle. Elle aide à traduire les intentions commerciales en actions réseau en analysant les données en temps réel et en adaptant les politiques réseau pour s’aligner avec des objectifs spécifiques.

- Automatisation et optimisation: L’automatisation pilotée par l’IA facilite l’implémentation de politiques basées sur l’intention à travers le réseau. Elle optimise les ressources et la performance réseau basées sur des intentions commerciales prédéfinies, réduisant l’intervention manuelle et améliorant l’efficacité opérationnelle.

- Évolutivité et flexibilité: L’évolutivité de l’IA lui permet de s’adapter à divers environnements et intentions réseau. Que ce soit dans le Cloud RAN, l’Open RAN ou le RAN traditionnel, l’IA peut être exploitée pour interpréter et exécuter les intentions réseau, assurant que le réseau évolue en réponse aux besoins commerciaux et conditions opérationnelles changeants.

Gestion du cycle de vie (LCM) des modèles d’IA

Une gestion efficace du cycle de vie des modèles d’IA est cruciale pour assurer la performance optimale des modèles d’IA/ML afin d’apporter plus d’adaptabilité dans les architectures réseau modernes. Cela implique plusieurs processus et méthodologies clés.

Collecte et préparation des données

Les modèles d’IA sont fondamentalement pilotés par les données, faisant de la collecte de données une première étape critique dans leur développement:

- Pour créer des modèles d’IA efficaces, il est essentiel de recueillir des données extensives de divers éléments réseau, y compris RAN, le coeur du réseaux et les applications.

- Ces données englobent le comportement utilisateur, les modèles de trafic et les métriques de performance réseau.

- La qualité et l’efficacité des résultats de l’IA dépendent de l’accès à des données amples, à jour et anonymisées pour l’entraînement.

- Les données brutes contiennent souvent des erreurs ou des valeurs manquantes qui doivent être nettoyées et formatées pour permettre aux modèles d’IA d’apprendre avec précision et efficacité.

Sélection et entraînement des modèles

Après la phase de préparation des données, la sélection d’un modèle d’IA approprié est cruciale:

- Le choix du modèle influence significativement la performance dans la reconnaissance de modèles et la précision de prédiction.

- Le modèle doit s’aligner avec le problème spécifique à adresser.

- Une fois le modèle et les données préparés, le processus d’entraînement peut commencer en utilisant les données traitées.

- Les algorithmes d’IA/ML doivent être entraînés pour comprendre les comportements sous-jacents du réseau ou d’environnements similaires.

- Des barrières de protection et des mécanismes de surveillance adéquats assurent que le réseau opère dans les paramètres attendus, maintenant la stabilité et la performance.

Évaluation, validation et déploiement

Après l’entraînement, le modèle subit une évaluation et une validation:

- Cette étape détermine si un développement supplémentaire est nécessaire, pouvant impliquer l’ajustement fin du modèle, l’optimisation des paramètres et le réentraînement pour améliorer la précision.

- Ce processus itératif est essentiel pour affiner le modèle et améliorer sa performance.

- Les modèles d’IA sont développés en utilisant à la fois des données historiques et en temps réel pour aborder des tâches spécifiques comme la gestion du trafic, l’équilibrage de charge ou la maintenance prédictive.

- Les ressources basées sur le cloud sont communément utilisées pour l’entraînement en raison de leur évolutivité et puissance de calcul, cruciales pour gérer de larges ensembles de données et des modèles complexes.

- Une fois le développement du modèle terminé, il est déployé et utilisé pour l’inférence, où le modèle est appliqué aux données réseau actuelles pour effectuer des tâches comme la détection d’anomalies ou l’optimisation du trafic.

- Une allocation efficace des ressources est vitale pour les tâches d’inférence, exploitant les ressources distribuées dans le Cloud RAN ou l’architecture modulaire de l’Open RAN pour assurer un traitement efficace des tâches d’inférence, réduisant la latence et améliorant la performance globale.

Conclusion et perspectives futures

La section 3 conclut en soulignant l’importance croissante de l’IA dans les réseaux cœur, OSS/BSS et la gestion réseau. Elle suggère que l’avenir verra une intégration encore plus profonde de l’IA, particulièrement de l’IA générative, dans ces systèmes.

Références

[1] TS 23.288 : Architecture enhancements for 5G System (5GS) to support network data analytics services : https://www.3gpp.org/ftp/Specs/archive/23_series/23.288/23288-j10.zip

[2] TS 29.520 : 5G System; Network Data Analytics Service, https://www.3gpp.org/ftp/Specs/archive/29_series/29.520/29520-j10.zips; Stage 3