Je remercie Rafika Rezgui (responsable New Deal Bouygues Télécom ) et Hugues-Antoine ROUSSILLO (Chef de projet Programme Réglementaire Bouyues Télécom) pour la relecture et les explications fournies qui ont contribuées à l’amélioration de l’article.

I) La mutualisation du RAN – RAN SHARING

L’architecture des réseaux de mobiles fait une séparation entre le réseau d’accès radio (RAN Radio Access Network) et le cœur de réseau (CN : Core Network).

Le partage du réseau (Network Sharing) a pour objectif de réduire les coûts de déploiement en partageant une partie du réseau entre opérateurs.

Selon la définition de l’ARCEP [1]: le partage de réseaux mobiles correspond à la mise en commun entre plusieurs opérateurs de tout ou partie des équipements constituant leurs réseaux mobiles.

On distingue ainsi plusieurs solutions sur le partage de l’accès radio :

- Location de site (Tower Companies) nommée partage d’infrastructure passive : chaque opérateur installe ses équipements actifs (antennes mobiles) sur une infrastructure passive partagée (pylône) ;

- La mutualisation active des réseaux (RAN Sharing)

- Avec partage de fréquences MOCN (Multi-Operator Core Network) : la station de base (ou le cœur d’accès radio) est connectée au cœur de réseau de plusieurs opérateurs et les porteuses de fréquence de chaque opérateur sont combinées. Les clients d’un opérateur peut donc accéder à l’ensemble des fréquences de l’ensemble des opérateurs [2]

- MORAN (Multi-Operator RAN) : La station de base est partagée entre plusieurs opérateurs mais chaque opérateur dispose de sa propre bande de fréquence. Les équipements mis en place par un des opérateurs émettent les fréquences des autres opérateurs mais chaque client n’a accès qu’aux fréquences de son opérateur. (exemple : Accord Crozon entre SFR et Bouygues)

- Full MVNO ou itinérance : un opérateur loue et utilise les fréquences d’un autre opérateur hôte qui accueille sur son réseau ses clients

- L’architecture GWCN (Gateway core network) pour laquelle plusieurs opérateurs partagent l’accès RAN et l’entité MME. L’entité MME doit évidemment supporter l’option RAN Sharing et doit pouvoir délivrer une liste de restriction d’eNB pour la continuité d’appels HO (Handover).

Figure 1 : La mutualisation du réseau de mobiles [1]

II) Exemple du New Deal

L’accord New Deal est un engagement imposé par le gouvernement aux opérateurs Français pour avoir une bonne couverture du réseau mobile. Cet engagement est encadré par l’ARCEP qui définit La notion de « bonne couverture ».

Une bonne couverture permet de téléphoner et d’échanger des SMS à l’extérieur des bâtiments dans la plupart des cas, et, dans certains cas, à l’intérieur des bâtiments (cf. https://www.arcep.fr/cartes-et-donnees/nos-cartes/la-couverture-4g-en-france-par-departement.html)

Le New Deal s’appuie sur la mutualisation radio (RAN SHARING). Le « New Deal » a pris la forme d’un « gentlemen’s agreement » matérialisé dans un échange de lettres, suivies d’annonces.

Le new deal utilise la mutualisation de l’accès radio (RAN Sharing) avec partage de fréquence (MOCN) ou sans partage de fréquence (MORAN).

La mutualisation MOCN est favorisée dans les zones blanches et la mutualisation MORAN dans les zones moins denses. Toutefois, Hugues-Antoine ROUSSILLO précise : « en cas de charge, la bande passante est limitée à ¼ des ressources par opérateur en MOCN ».

III) Les évolutions du spectre radiomobile

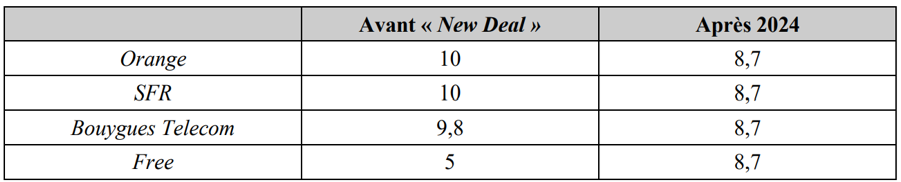

A partir de 2024, les plans de fréquences à 900 MHz, 1800 MHz et 2100 MHz seront équilibrés entre les opérateurs (suivant [3]) :

Tableau 3 : Bande de 2100 MHz

Notes

Le NB-IoT ne supporte pas le RAN SHARING (jusqu’à la R.17)

Références

[1] https://www.arcep.fr/la-regulation/grands-dossiers-reseaux-mobiles/le-partage-de-reseaux-mobiles.html

[2] Rapport de la cours de comptes : Réduire la fracture numérique mobile (Juin 2021) : https://www.ccomptes.fr/sites/default/files/2021-09/20210928-58-2-reduire-fracture-numerique-mobile-4G.pdf

[3] Décision n° 2018-1306 du 23 octobre 2018 : https://www.legifrance.gouv.fr/jorf/id/JORFTEXT000038057322

Figure 1 : Pré-configuration du terminal par la station de base

Figure 1 : Pré-configuration du terminal par la station de base Figure 2 : La transmission PUR avec l’optimisation du plan de contrôle

Figure 2 : La transmission PUR avec l’optimisation du plan de contrôle

Figure 2 : Les couches protocolaires de l’interface radio

Figure 2 : Les couches protocolaires de l’interface radio